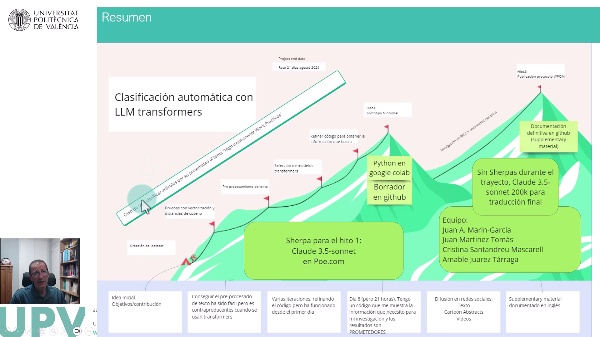

Reto21dias_ago24-Codificación y clasificación automática (NLM vs IA generativa LLM). Resumen día 6. Pre-procesamiento del texto

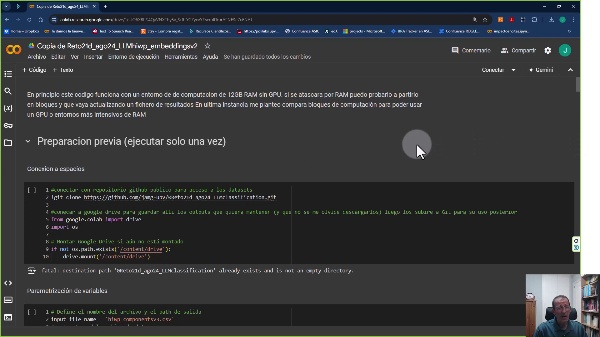

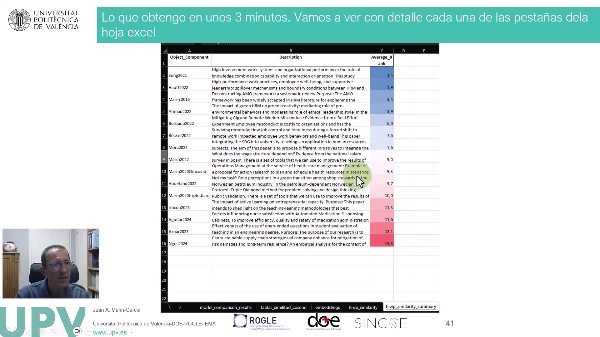

En mi sexto día del reto, me he centrado en tareas de procesamiento o preprocesamiento de datos. Partiendo de lo que había aprendido en días anteriores, me he metido en el código para realizar la limpieza y preparación del texto. Para mi sorpresa, he descubierto que realmente no es necesario hacer este preprocesamiento. Aunque he logrado implementar con éxito el código que Claude 3.5 Sonet me proporcionó, al ver los resultados, me he dado cuenta de que no es lo que necesito para mi caso de uso. El código que he desarrollado realiza varias etapas típicas de preprocesamiento, como convertir a minúsculas, eliminar caracteres especiales, tokenizar el texto, eliminar palabras vacías, lematizar y generar n-gramas. Sin embargo, al ver el resultado final, donde el texto rico y con su gramática original se convierte en un vector de palabras independientes, me ha hecho dudar sobre si realmente este procesamiento es útil para mi tarea de clasificación utilizando embeddings de Transformers. Posteriormente, he consultado a mi asistente de IA favorita, Claude 3.5 Sonet, quien me ha confirmado que en este caso, donde voy a utilizar modelos de Transformers, es mejor no realizar un preprocesamiento tan exhaustivo, ya que estos modelos pueden capturar el significado y el contexto del texto sin necesidad de transformarlo en una bolsa de palabras. Así que, a pesar de haber tenido éxito en la implementación del código de preprocesamiento, he decidido no utilizarlo. En su lugar, voy a trabajar directamente con el texto original, tal como viene en las definiciones, ya que creo que esto será más beneficioso para mi tarea de clasificación utilizando embeddings de Transformers. Reconozco que en otros casos de uso, donde se trabaje más con coocurrencia de palabras, este tipo de preprocesamiento podría ser útil e interesante. Pero para mi caso particular, he decidido no aplicarlo y confiar en la capacidad de los modelos de Transformers para capturar el significado y el contexto del texto. #ProcesamientoLenguajeNatural #AprendizajeAutomático #MétodosInvestigación #LLM #ML #NLP #reto21dias

8:54 · 2024

2:30 · 2024

19:30 · 2024